Ministros são alertados sobre o uso de IA treinada com o trabalho de artistas

Isso está começando a mudar à medida que a questão de quais dados são usados para IA, e o valor dessa informação, se torna um tópico quente

Fonte: https://www.businessinsider.com/data-leverage-harry-potter-test-putting-value-data-ai-models-2023-8

Anos antes do ChatGPT, Nick Vincent estudava o quanto a IA depende de dados gerados por humanos. Uma coisa sempre o impressionou sobre os pesquisadores e empresas de tecnologia por trás desses modelos poderosos: "Eles sempre destacam seus algoritmos inteligentes, não os dados subjacentes", disse Vincent, professor assistente de ciência da computação na Universidade Simon Fraser, perto de Vancouver.

Isso está começando a mudar à medida que a questão de quais dados são usados para IA, e o valor dessa informação, se torna um tópico quente. Grandes modelos, como o GPT-4 da OpenAI, o PaLM 2 do Google e o Llama 2 da Meta, foram parcialmente construídos com base em milhões de livros, artigos, chats online e outros conteúdos postados online. Alguns dos criadores por trás dessas obras processaram alegando violações de direitos autorais, enquanto outros querem ser pagos por suas contribuições.

Mas como você pode medir o valor de um dado específico quando um grande modelo de IA absorveu a maior parte do que foi publicado online na última década ou mais? Esse problema foi destacado em um recente blog sobre IA pelo analista de tecnologia Benedict Evans: "Não precisa do seu livro ou site em particular e não se importa com o que você escreveu, mas precisa de 'todos' os livros e 'todos' os sites. Funcionaria se uma empresa removesse seu conteúdo, mas não se todos fizessem isso."

Vincent, o professor, chama isso de "Alavancagem de Dados". Se as comunidades souberem melhor o valor de seus dados para os modelos de IA, elas podem negociar mais efetivamente o pagamento por seu trabalho. "Se soubermos que todos os nossos livros juntos são responsáveis por metade da 'qualidade' do ChatGPT, então podemos atribuir um valor a isso", disse ele. "Era um conceito marginal há alguns anos e está se tornando mais comum agora. Estou chocado em ver isso acontecer."

O QUE FAZ OS LLMs FUNCIONAREM?

Neste mês, pesquisadores sérios de IA entraram neste debate com 2 artigos que buscam abordar vários aspectos da situação. Em 7 de agosto, a Anthropic, uma das empresas de IA mais avançadas do mundo, publicou um artigo de pesquisa descrevendo uma nova maneira de trocar dados de forma mais eficiente e avaliar como o desempenho do modelo muda. Até agora, esses tipos de ajustes em grandes modelos de linguagem têm sido tão caros que realmente não foram tentados.

"Quando um LLM emite informações que sabe serem falsas, resolve corretamente problemas de matemática ou programação, ou implora ao usuário para não desligá-lo, ele está simplesmente regurgitando (ou juntando) passagens do conjunto de treinamento? Ou está combinando seu conhecimento armazenado de maneiras criativas e construindo um modelo de mundo detalhado?", escreveram os pesquisadores da Anthropic. "Acreditamos que este trabalho é o primeiro passo para uma abordagem de cima para baixo para entender o que faz os LLMs funcionarem."

SILO E VALOR DO CONTEÚDO DE ALTA QUALIDADE

Em seguida, veio o SILO, um novo modelo de linguagem desenvolvido por pesquisadores da Universidade de Washington em Seattle, UC Berkeley e o Allen Institute for AI. Seu objetivo geral era criar um modelo que pudesse remover dados para reduzir riscos legais. No processo, eles também desenvolveram uma maneira de medir como dados específicos contribuem para a saída de um modelo de IA.

"O SILO poderia fornecer um caminho para os proprietários de dados serem devidamente creditados (ou serem pagos diretamente) toda vez que seus dados em um datastore contribuíssem para uma previsão", escreveram os pesquisadores em um artigo revelando a tecnologia em 8 de agosto.

Os autores resolveram uma questão importante imediatamente: os modelos de IA dependem fortemente de conteúdo humano de alta qualidade que muitas vezes está protegido por direitos autorais. Sem isso, o desempenho começa a decair fortemente. "Como mostramos, o desempenho do modelo degrada significativamente se treinado apenas em texto de baixo risco (por exemplo, livros fora de direitos autorais ou documentos governamentais), devido ao seu tamanho limitado e cobertura de domínio", escreveram eles.

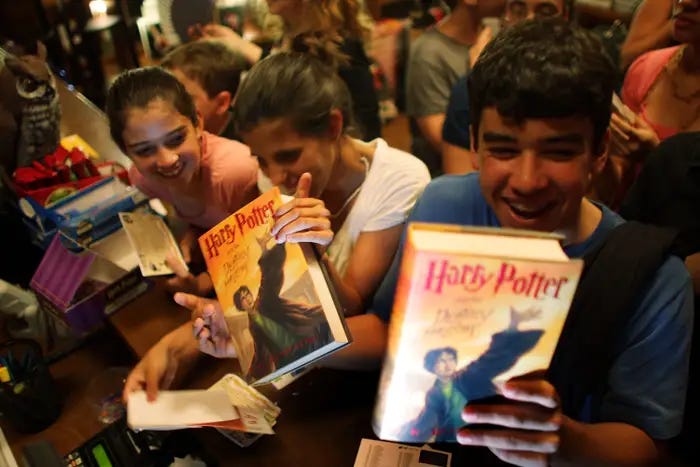

O TESTE HARRY POTTER

Em seguida, os pesquisadores aprofundaram-se no assunto, usando os livros de Harry Potter de J.K. Rowling para ver se partes individuais de dados influenciam o desempenho do modelo de IA. Eles começaram com uma grande coleção de livros publicados que fazem parte de The Pile, um enorme conjunto de dados que foi construído raspando e armazenando muito do que foi postado online ao longo dos anos.

Então, eles criaram 2 "datastores". Um tinha todos os livros publicados, exceto o primeiro livro de Harry Potter. O outro datastore excluiu todos os 7 livros de Harry Potter. Eles realizaram testes para ver como o modelo se saía usando esses 2 diferentes datastores. Em seguida, repetiram o exercício, excluindo o segundo livro de Harry Potter, depois o terceiro e assim por diante. A ideia com essa análise de "exclusão" era ver o quão bem o modelo se saía quando esses conteúdos estavam faltando.

"Quando os livros de Harry Potter são removidos do datastore, a perplexidade piora", descobriram os pesquisadores. A perplexidade mede a precisão dos modelos de IA. Portanto, sem Harry Potter, o modelo não é tão bom. A conclusão mais específica parece dolorosamente lógica, mas é importante: se você retirar um conteúdo específico, os LLMs não conseguem responder bem sobre esse conteúdo.

"Os LLMs ameaçam nossa capacidade de fazer essas conclusões óbvias", disse Vincent. "Até agora, jogar todos os dados em um modelo de IA tem funcionado bem. Então, houve menos necessidade de saber especificamente que dados estão ajudando a tornar um modelo bom."

BENEFÍCIOS LEGAIS IMPORTANTES

Ajudar J.K. Rowling a ganhar ainda mais dinheiro com seus livros de Harry Potter não era o objetivo do estudo SILO. O que os pesquisadores provaram é que é possível construir modelos de IA poderosos enquanto se mitiga o risco legal, de acordo com Oren Etzoni, ex-CEO do Allen Institute for AI, que continua sendo membro do conselho e consultor da organização.

Os pesquisadores treinaram o modelo SILO apenas em conjuntos de dados de baixo risco que continham texto de domínio público, como livros cujos direitos autorais expiraram. Um próximo passo importante é chamado de inferência, onde o modelo usa seu treinamento para interpretar novas informações e decidir a melhor saída ou curso de ação. A fase de inferência é onde os pesquisadores introduziram os dados de alto risco, incluindo esses livros protegidos por direitos autorais, juntamente com artigos de notícias, texto médico e outros conteúdos. Foi onde aconteceram os testes de "exclusão" de Harry Potter.

Esta abordagem tem importantes benefícios legais, segundo Etzioni. Os autores podem optar por sair a qualquer momento, e o modelo não precisa ser re-treinado. Além disso, frases específicas podem ser atribuídas nos resultados, permitindo que o crédito seja atribuído aos autores. "No entanto, se os autores insistirem em optar por sair em massa, então o SILO não acabará sendo útil na prática", acrescentou ele. E é legal usar obras protegidas por direitos autorais na fase de inferência do desenvolvimento de um modelo de IA? "Essa é uma questão para um advogado de direitos autorais", disse Etzioni.