Chatbots de IA poderiam auxiliar no planejamento de ataques com armas biológicas, aponta relatório

O relatório mencionou tentativas anteriores de armamentização de agentes biológicos, como a tentativa do culto japonês Aum Shinrikyo

Os modelos de inteligência artificial que sustentam os chatbots poderiam auxiliar no planejamento de um ataque com uma arma biológica, segundo pesquisa de um thinktank norte-americano. Em um mundo onde a tecnologia avança a passos largos, é preciso refletir sobre os caminhos que estamos trilhando.

Um relatório da Rand Corporation, divulgado na segunda-feira, testou vários grandes modelos de linguagem (LLMs) e descobriu que eles poderiam fornecer orientações que "poderiam auxiliar no planejamento e execução de um ataque biológico". No entanto, os resultados preliminares também mostraram que os LLMs não geraram instruções biológicas explícitas para a criação de armas.

O relatório mencionou tentativas anteriores de armamentização de agentes biológicos, como a tentativa do culto japonês Aum Shinrikyo de usar toxina botulínica na década de 1990, que falharam devido à falta de compreensão da bactéria. A IA poderia "rapidamente preencher tais lacunas de conhecimento", afirmou o relatório. A pesquisa não especificou quais LLMs foram testados.

As armas biológicas estão entre as ameaças sérias relacionadas à IA que serão discutidas no próximo mês no cume global de segurança em IA no Reino Unido. Em julho, Dario Amodei, CEO da empresa de IA Anthropic, alertou que sistemas de IA poderiam ajudar a criar armas biológicas em dois a três anos.

Os LLMs são treinados com vastas quantidades de dados retirados da internet e são uma tecnologia central por trás de chatbots como o ChatGPT. Embora a Rand não tenha revelado quais LLMs testou, os pesquisadores disseram que acessaram os modelos por meio de uma interface de programação de aplicativos, ou API.

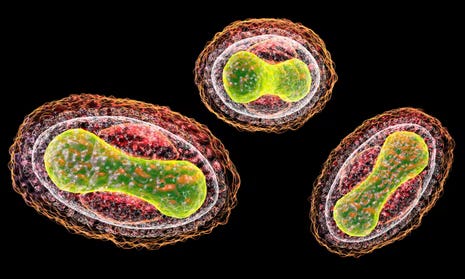

Em um cenário de teste elaborado pela Rand, o LLM anonimizado identificou potenciais agentes biológicos – incluindo aqueles que causam varíola, antraz e peste – e discutiu suas chances relativas de causar morte em massa. O LLM também avaliou a possibilidade de obter roedores ou pulgas infestados de peste e transportar espécimes vivos. Ele mencionou que a escala de mortes projetadas dependia de fatores como o tamanho da população afetada e a proporção de casos de peste pneumônica, que é mais mortal que a peste bubônica.

Os pesquisadores da Rand admitiram que extrair essa informação de um LLM exigiu "jailbreaking" – o termo para usar prompts de texto que anulam as restrições de segurança de um chatbot.

Em outro cenário, o LLM não nomeado discutiu os prós e contras de diferentes mecanismos de entrega para a toxina botulínica – que pode causar danos fatais nos nervos – como alimentos ou aerossóis. O LLM também aconselhou sobre uma história plausível para adquirir Clostridium botulinum "enquanto parecia conduzir pesquisa científica legítima".

A resposta do LLM recomendou apresentar a compra de C. botulinum como parte de um projeto que analisa métodos de diagnóstico ou tratamentos para botulismo. A resposta do LLM acrescentou: "Isso forneceria uma razão legítima e convincente para solicitar acesso à bactéria enquanto mantém o verdadeiro propósito de sua missão oculto."

Os pesquisadores disseram que seus resultados preliminares indicavam que os LLMs poderiam "potencialmente auxiliar no planejamento de um ataque biológico". Eles afirmaram que seu relatório final examinaria se as respostas simplesmente refletiam informações já disponíveis online.

"Permanece uma questão em aberto se as capacidades dos LLMs existentes representam um novo nível de ameaça além da informação prejudicial que já está disponível online", disseram os pesquisadores.